Ein neuer Ansatz ermöglicht erstmals die Erstellung und Steuerung fotorealistischer digitaler Avatare auf Grundlage des Inputs einer einzigen, am Körper getragenen RGB-Kamera.

Jianchun Chen, Doktorand am MPI für Informatik und Erstautor von „EgoAvatar“, präsentiert den Forschungsprototyp des am Kopf getragenen Kamerasystems. Foto: Philipp Zapf-Schramm / MPI-INF

Wenn sich digitale Meetings nicht mehr von echten Zusammentreffen unterscheiden ließen, könnte das die Telekommunikation grundlegend verändern. Doch dazu braucht es leicht zugängliche, hardware-effiziente Techniken, mit denen Nutzende realistische virtuelle Avatare erzeugen können. Ein Forschungsteam unter Beteiligung des Max-Planck-Instituts für Informatik, des „Saarbrücken Research Center for Visual Computing, Interaction and Artificial Intelligence“ (VIA) und Google hat einen Ansatz entwickelt, mit dem erstmals aus dem Input einer einzigen am Kopf getragenen Kamera echt wirkende, digitale Abbilder kreiert werden können.

„Die größte technische Herausforderung ist die Kombination zweier Aspekte: Zum einen muss ein Avatar erzeugt werden, der die reale Person in Aussehen und Bewegung möglichst präzise erfasst und widerspiegelt. Zum anderen soll all das mit minimaler Hardware, aus der Ich-Perspektive, mit nur einer einzigen am Kopf getragenen Kamera geschehen“, erklärt der Erstautor der Studie, Jianchun Chen, Doktorand am Max-Planck-Institut für Informatik und der Universität des Saarlandes. Bisherige Ansätze behandelten nur Teilaspekte des Problems und konzentrierten sich entweder nur auf Kopf-Avatare, nutzten aufwendige Multi-Kamera-Setups zur Erstellung der Avatare, oder lieferten keine fotorealistische Darstellung. „Unser Ansatz verbindet erstmals fotorealistische Animation mit sogenannter egozentrischer Bewegungserfassung in einer einzigen Methode.Das ist ein wichtiger Schritt hin zu immersiver VR-Telepräsenz“, sagt Professor Christian Theobalt, wissenschaftlicher Direktor am Max-Planck-Institut für Informatik und Gründungsdirektor des VIA-Centers.

Bei der Methode namens „EgoAvatar“ handelt es sich um Grundlagenforschung. Aktuell ist der Ansatz noch personenspezifisch, das heißt, es muss zunächst in einem zweischrittigen Verfahren ein individuelles Modell jedes Nutzers erstellt werden. Dies geschieht mithilfe eines Motion-Capture-Studios am Max-Planck-Institut für Informatik. Dort werden zunächst Bewegungsmuster und die Wechselwirkungen zwischen Körper, Kleidung und Lichtverhältnissen detailliert erfasst. Auf dieser Grundlage wird ein Modell davon erstellt, wie sich die jeweilige Person bewegt und wie ihre Kleidung auf Bewegungen reagiert.

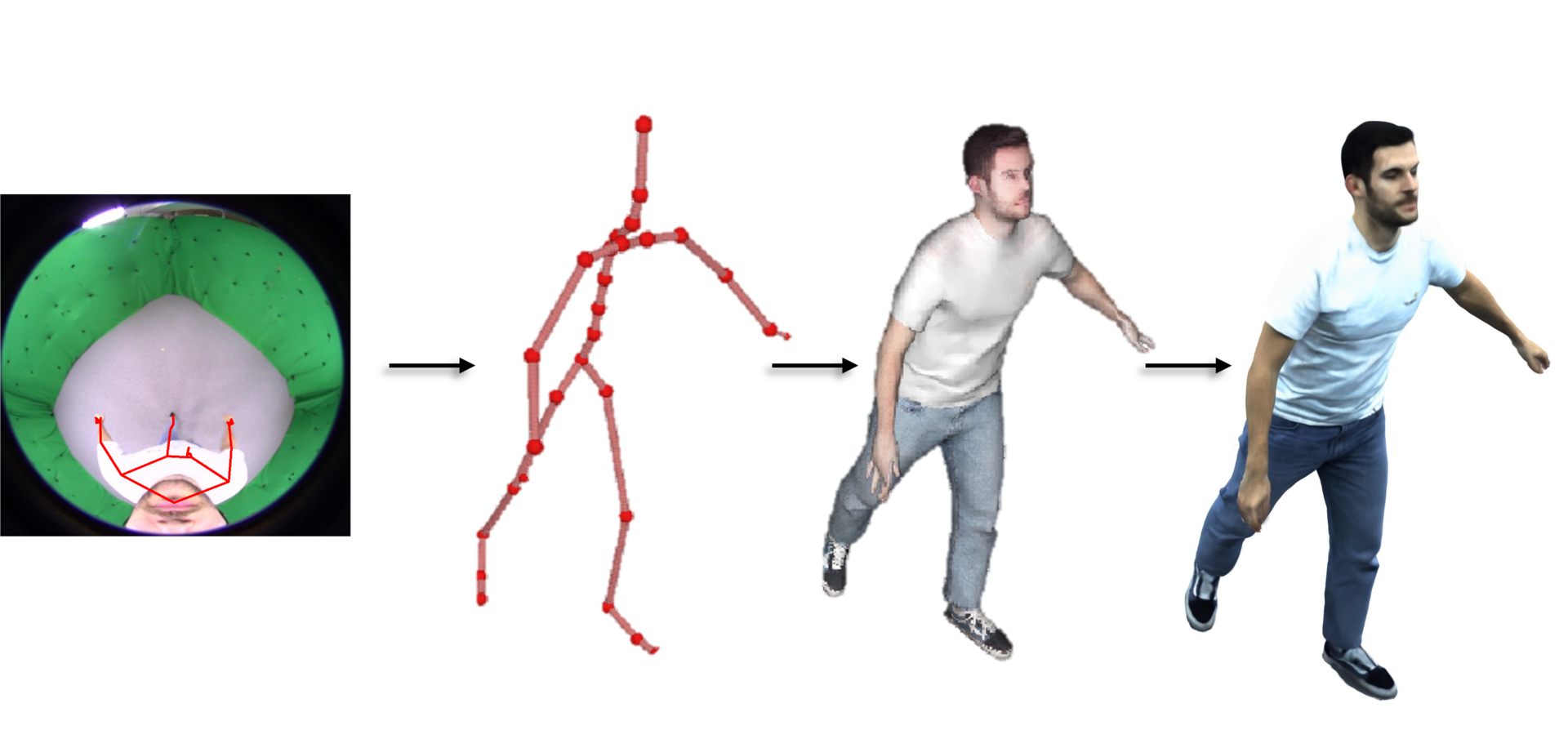

Um einen fotorealistischen Ganzkörper-Avatar ausschließlich aus einem Video-Input aus der Ich-Perspektive (links) zu erzeugen, erfassen und rekonstruieren wir schrittweise 3D-Schlüsselpunkte, Skelett, Mesh und gaußsche Primitive. Dies ermöglicht eine originalgetreue 4K-Rendering- und Darstellungsqualität (rechts) aus einer frei wählbaren Perspektive. Urheber: Jianchun Chen

Mit diesem Modell als Basis kann EgoAvatar anschließend aus einer einzigen, nach unten gerichteten Körperkamera das Aussehen und die Bewegung einer Person erfassen und rekonstruieren. Kern der Arbeit ist ein mehrstufiges Verfahren, das zunächst die Körperbewegung analysiert und daraus eine präzise, steuerbare Skelettdarstellung ableitet. Anschließend wird eine 3D-Rekonstruktion generiert, die nicht nur die Körperform, sondern auch feinste Details von Kleidung und Oberflächenstrukturen realistisch abbildet. Während dieses Prozesses wird das vorab trainierte Modell optimiert, um sich exakt an die (Ego)-Kameraperspektive anzupassen und wirklichkeitsnahe Bewegungen wiederzugeben. Abschließend wird das digitale Abbild fotorealistisch gerendert – mit realistischen Textur- und Materialeigenschaften, sodass der Avatar aus beliebigen Blickwinkeln betrachtet werden kann.

Die neue Methode kombiniert mehrere, miteinander verknüpfe Entwicklungen des Max-Planck-Instituts für Informatik zu einem neuen Verfahren. „Unser Ziel ist es, langfristig die Notwendigkeit des aufwändigen Vorab-Trainings zu überwinden“, erklärt Christian Theobalt.

Die Wissenschaftler evaluierten und testeten ihre Methode in einem anspruchsvollen, selbst entwickelten Benchmark. Dabei wurden die aus der Einzelkamera rekonstruierten Avatare systematisch mit den hochpräzisen 3D-Referenzmodellen aus einem 120-Kamera-Setup verglichen. Die Ergebnisse zeigen, dass EgoAvatar genauere Bewegungsrekonstruktionen und realistischere visuelle Details liefert als bisherige Verfahren.

Das Team veröffentlichte das Paper unter dem Titel „EgoAvatar: Egocentric View-Driven and Photorealistic Full-body Avatars“ auf der 2024er Auflage der „ACM SIGGRAPH Conference and Exhibition on Computer Graphics and Interactive Techniques in Asia“ (SIGGRAPH ASIA), die vom 3. bis 6. Dezember 2024 in Tokyo, Japan, stattfand. Die SIGGRAPH ASIA zählt zu den weltweit führenden Fachkonferenzen in den Bereichen Computer Grafik und Visual Computing. Bei Egoavatar handelt es sich um eine Kooperation der Abteilung „Visual Computing and Artificial Intelligence“ am Saarbrücker Max-Planck-Institut für Informatik mit dem ebenfalls dort angesiedelten „Saarbrücken Research Center for Visual Computing, Interaction and Artificial Intelligence“, einer 2022 gestarteten strategischen Forschungspartnerschaft mit Google, das somit ebenfalls an dem Projekt beteiligt war.

Originalpublikation:

Chen, J., Wang, J., Zhang, Y., Pandey, R., Beeler, T., Habermann, M., Theobalt, C. (2024): „EgoAvatar: Egocentric View-Driven and Photorealistic Full-body Avatars“. 17th ACM SIGGRAPH Conference and Exhibition on Computer Graphics and Interactive Techniques in Asia (SIGGRAPH ASIA). https://dl.acm.org/doi/10.1145/3680528.3687631

Kontakt und Redaktion:

Philipp Zapf-Schramm

Max-Planck-Institut für Informatik

Tel: +49 681 9325 5409

E-Mail: pzs@mpi-inf.mpg.de